Świat jest zachwycony pozorną mocą ChatGPT i podobnych programów do tworzenia narracji na poziomie ludzkim i generowania obrazów za pomocą prostych poleceń. Wielu ulega pokusie ekstrapolacji tych mocy do bliskiej nieskończoności, czyli Osobliwości, w której AI osiąga Nirwanę superinteligencji.

−∗−

Co ChatGPT i DeepMind mówią nam o sztucznej inteligencji

Co ciekawe, naprawdę trudnym problemem, do którego sztuczna inteligencja nie została zastosowana, jest zarządzanie tymi technologiami w naszym systemie społeczno-ekonomicznym i kulturowym.

Świat jest zachwycony pozorną mocą ChatGPT i podobnych programów do tworzenia narracji na poziomie ludzkim i generowania obrazów za pomocą prostych poleceń. Wielu ulega pokusie ekstrapolacji tych mocy do bliskiej nieskończoności, czyli Osobliwości, w której AI osiąga Nirwanę superinteligencji.

Cała ta ekscytacja jest fajna, ale rozsądniej jest zacząć od umieszczenia ChatGPT w kontekście historii sztucznej inteligencji i naszego systemu społeczno-ekonomicznego.

Zainteresowałem się sztuczną inteligencją na początku lat 80. i przeczytałem wiele książek czołowych badaczy sztucznej inteligencji tamtych czasów.

Początki sztucznej inteligencji datuje się na lata 60. XX wieku. Zaczęło się od marzenia o Universal General Intelligence. Maszynie obliczeniowej, która dorównywałaby ludzkiej zdolności do zastosowania uogólnionej inteligencji do dowolnego problemu.

To szybko doprowadziło do zniechęcającego uświadomienia sobie, że ludzka inteligencja to nie tylko logika czy rozum. Był to niezwykle złożony system, który zależał od wzroku, heurystyki (reguł opartych na doświadczeniu), sprzężenia zwrotnego i wielu innych podsystemów.

Sztuczna inteligencja pokazowo przechodzi przez cykle zafascynowania jej rozwojem, po których następują spadki zainteresowania z powodu świadomości ograniczeń postępów.

Wzrost mocy obliczeniowej i programowania w latach 80. XX wieku doprowadził do postępu w kilku poddziedzinach: systemy wizyjne, algorytmy zawierające heurystykę i tak dalej.

W tym samym czasie filozofowie tacy jak Hubert Dreyfus i John Searle badali, co rozumiemy przez wiedzieć i rozumieć, i kwestionowali, czy komputery kiedykolwiek osiągną to, co nazywamy „rozumieniem”.

Ten artykuł (spośród wielu innych) podsumowuje krytykę sztucznej inteligencji, która jest w stanie powielić ludzkie rozumienie: Intentionality and Background: Searle and Dreyfus against Classical AI Theory [Intencjonalność i tło: Searle i Dreyfus przeciwko klasycznej teorii sztucznej inteligencji].

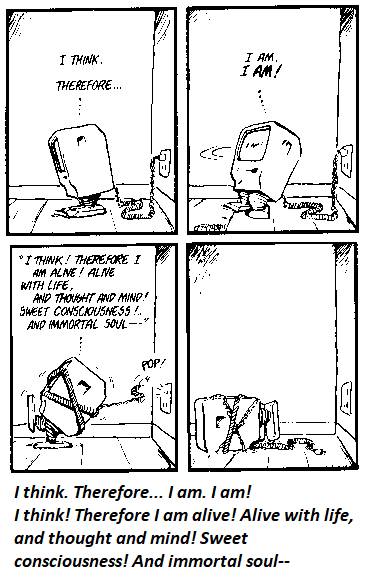

Mówiąc najprościej, czy uruchomienie skryptu/algorytmu faktycznie „zrozumiało” problem tak, jak rozumieją ten problem ludzie?

Odpowiedź, oczywiście, brzmi nie. Test Turinga – zaprogramowanie komputera tak, aby naśladował ludzki język i reakcje – można oskryptować / zaprogramować, ale to nie znaczy, że komputer posiądzie ludzkie rozumienie. To po prostu destylacja ludzkich odpowiedzi poprzez heurystykę, która naśladuje ludzkie reakcje.

Jednym z rezultatów tej dyskusji na temat świadomości i rozumienia [consciousness and understanding] było odejście sztucznej inteligencji od marzenia o Ogólnej Inteligencji [General Intelligence] do specyfiki uczenia maszynowego.

Innymi słowy, mniejsza o to czy sztuczna inteligencja naśladuje ludzkie rozumienie, po prostu pozwólmy jej rozwiązywać złożone problemy.

Podstawową ideą uczenia maszynowego jest przekształcenie ograniczeń i zasad systemu w algorytmy, a następnie umożliwienie programowi zastosowania tych narzędzi do rzeczywistych przykładów.

Biorąc pod uwagę wystarczającą liczbę rzeczywistych przykładów, system opracowuje heurystykę (reguły oparte na doświadczeniu) dotyczącą tego, co działa, a co nie, a co niekoniecznie jest widoczne dla badaczy.

W efekcie program uczenia maszynowego staje się „czarną skrzynką”, w której jego postępy są nieprzejrzyste dla tych, którzy zaprogramowali jego narzędzia i zdigitalizowali rzeczywiste przykłady w formy, z którymi program może pracować.

Ważne jest, aby odróżnić to uczenie maszynowe od analizy statystycznej za pomocą algorytmów statystycznych.

Na przykład, jeśli program został zaprojektowany do wyszukiwania wzorców i statystycznie istotnych korelacji, przegląda miliony profili w mediach społecznościowych oraz historie zakupów i stwierdza, że republikańscy internauci mieszkający (powiedzmy) w Delaware prawdopodobnie są fanami Chipotle [rodzaj papryki -tłum].

Ta analiza statystyczna nazywa się „big data” i chociaż ma oczywiste zastosowania w marketingu wszystkiego, od kandydatów aż po burrito, nie kwalifikuje się jako uczenie maszynowe.

W podobny sposób algorytmy, takie jak ChatGPT, które generują narracje w języku naturalnym z baz danych i heurystyki, nie kwalifikują się jako uczenie maszynowe, chyba że modyfikują postępy w „czarnej skrzynce”, w której dane wejściowe (żądanie) są znane, a dane wyjściowe też są znane, ale nieznany jest proces.

Google ma zespół ds AI o nazwie DeepMind, który podjął się niezwykle złożonego zadania polegającego na ustaleniu, w jaki sposób białka zbudowane z tysięcy sekwencji aminokwasów składają się w zwarte kształty w ciągu nanosekund.

Problemu obliczenia wszystkich możliwych fałd w 200 milionach różnych białek nie można rozwiązać zwykłym obliczeniem wszystkich permutacji metodą “na siłę”, dlatego wymagało to podzielenia każdego etapu procesu na algorytmy.

Ostateczny produkt, AlphaFold, ma 32 algorytmy składowe, z których każdy obejmuje różne bazy wiedzy z odpowiednich dyscyplin (biochemia, fizyka itp.).

DeepMind’s AI Makes Gigantic Leap in Solving Protein Structures [Sztuczna inteligencja DeepMind dokonuje gigantycznego skoku w rozwiązywaniu struktur białkowych].

Oto jak lider projektu, Demis Hassabis, opisuje możliwości „czarnej skrzynki”:

„To jasne, że AlphaFold 2 uczy się czegoś ukrytego na temat struktury chemii i fizyki. W pewnym sensie wie, jakie rzeczy mogą być wiarygodne.

Myślę, że AlphaFold uchwycił coś dość głębokiego na temat fizyki i chemii cząsteczek… prawie uczy się o tym w intuicyjnym sensie.”

Ale są granice tego, co AlphaFold może zrobić i w czym jest dobry: „Myślę, że będzie coraz więcej badaczy przyglądających się tym obszarom białek, w przewidywaniu których AlphaFold nie jest dobry”.

Innymi słowy, nie można powiedzieć, że AlphaFold „rozumie” całość fałdowania białek. Jest dobry w ograniczaniu możliwych fałd do podzbioru i przedstawiania tych możliwości w formie, którą można porównać z rzeczywistymi strukturami białek zidentyfikowanymi w procesach laboratoryjnych. Może również przypisać poziom zaufania do każdej ze swoich prognoz.

Jest to przydatne, ale dalekie od „rozumienia”, a twierdzenie, że jest inaczej, jest krzywdzące.

Co ciekawe, naprawdę trudnym problemem, do którego sztuczna inteligencja nie została zastosowana, jest zarządzanie tymi technologiami w naszym systemie społeczno-ekonomicznym i kulturowym.

________________

What ChatGPT and DeepMind Tell Us About AI, Charles Hugh Smith, February 20, 2023

−∗−

Powiązane tematycznie:

AI jest bezwartościowa czyli kto zdemontuje elity

Z punktu widzenia relacji władzy, jeśli AI nie jest w stanie zdemontować istniejącej struktury władzy, to jest bezwartościowa. W obecnej strukturze władzy społeczeństwo i obywatele służą naszym korporacyjnym/państwowym władcom. Odkładając […]

Ciekawostka z 2017r.

Sztuczna inteligencja rozgromiła pokerzystów, 31 stycznia 2017