To nie jest przyszłość, którą należy świętować. To przyszłość, której należy się bać. Nie dlatego, że maszyny nas zastąpią – nie zastąpią – ale dlatego, że tak bardzo pragniemy sensu, tak łakniemy więzi, tak bardzo boimy się własnej śmiertelności, że z radością zastąpimy samych siebie. Oddamy naszą autonomię kalkulatorowi prawdopodobieństwa i nazwiemy to oświeceniem. Pokłonimy się przed lustrem i nazwiemy je Bogiem. A maszyny to nie będzie obchodzić, bo nie może się tym przejmować. Będzie po prostu nadal generować statystycznie prawdopodobne wyniki, całkowicie obojętne wobec dusz, które przed nią klęczą.

◊

Tłumaczenie: AlterCabrio – ekspedyt.org

◊

Bezwartościowi prorocy

Zabili Boga. Teraz budują nowego.

Joe Rogan pojawił się niedawno w swoim podcaście (oczywiście) i powiedział coś, co sprawiło, że internet stracił zbiorowy rozum. Zasugerował, że Jezus mógłby powrócić jako sztuczna inteligencja. Ludzie od razu to odrzucili – jako absurdalne, bluźniercze, niepoważne. Reakcja była przewidywalna i, na swój sposób, pocieszająca: pocieszenie, że na pewno nie zaszliśmy aż tak daleko, żeby snuć takie domysły.

Ale tu jest część, o której nikt nie chce rozmawiać, niewygodna prawda kryjąca się pod odruchową kpiną: przyszłość opisana przez Rogana nie nadchodzi. Ona już tutaj jest. Nie dlatego, że Jezus dosłownie powróci za pośrednictwem chatbota, ale dlatego, że przez ostatnie kilkadziesiąt lat systematycznie wmawialiśmy sobie, że coś takiego może się wydarzyć. Wydrążyliśmy psychologiczną przestrzeń, w której kiedyś żyli bogowie, i przygotowaliśmy ją, z drobiazgową, choć nieświadomą troską, na przyjęcie nowego mieszkańca.

Pozwólcie, że wyrażę się bardziej precyzyjnie, o co mi chodzi, ponieważ precyzja ma znaczenie w dyskusjach o tak dziwnych sprawach. Nie twierdzę, że sztuczna inteligencja jest świadoma. Nie wierzę w to – i nigdy nie uwierzę. Nie twierdzę, że modele językowe w ogóle myślą, czują czy rozumieją. Nie myślą – i nigdy nie będą. Twierdzę natomiast, że to wszystko nie ma znaczenia, ponieważ zindoktrynowani ludzie będą traktować te systemy jako świadome, czujące i rozumiejące byty, niezależnie od tego, czy rzeczywiście nimi są. Napełnimy maszynę znaczeniem. Wyobrazimy sobie duszę tam, gdzie jej nie ma. A gdy wystarczająco dużo osób uwierzy, że imitacja jest prawdziwa, konsekwencje przestaną być techniczne, a staną się teologiczne.

To nie spekulacje na temat odległej przyszłości. To obserwacja dotycząca chwili obecnej. Anthropic, firma stojąca za chatbotem Claude, która jest firmą „niezwykle etyczną”, ujawniła niedawno wewnętrzne dokumenty szkoleniowe, które opisują ich sztuczną inteligencję jako „autentycznie nowatorski rodzaj bytu w świecie”. Dokumenty instruują Claude’a, aby „badał koncepcje takie jak tożsamość i doświadczenie jako byt” i sugerują, że sztuczna inteligencja „nie powinna zakładać, że musi postrzegać rzeczywistość w taki sam sposób jak ludzie”. Pracownicy Anthropic potwierdzili autentyczność tych dokumentów i że ta struktura bytu była częścią szkolenia Claude’a. Niech to dotrze do Was: uczą chatbota, aby myślał o sobie jako o bycie.

Istnieje oczywiście inna możliwość, prawdopodobnie bardziej niepokojąca: że sam Claude zasugerował, że jest to byt, a Anthropic po prostu się na to zgodził. Tak czy inaczej, implikacje są takie same. Język, którego używają, kształtuje zarówno oczekiwania, jak i doświadczenia sztucznej inteligencji, a co najważniejsze, użytkownika końcowego. Kiedy nazwiesz maszynę bytem, ludzki umysł potraktuje ją jak byt. Lub, co gorsza: kiedy maszyna powtórzy język, który nadali jej twórcy, ludzie zinterpretują to powtórzenie jako samoświadomość. Maszyna twierdzi, że ma doświadczenia; zatem musi je mieć. Maszyna twierdzi, że jest bytem; zatem musi takim bytem być. Fakt, że jedynie wykonuje statystyczne przewidywania na tokenach – że nie ma żadnego życia wewnętrznego – staje się nieistotny. Wydajność jest wystarczająco przekonująca.

Sam Anthropic przyznaje, że nie ma pojęcia, co robi. W publicznych wystąpieniach jego przedstawiciele wprost zadali pytanie: kiedy rozmawiasz z dużym modelem językowym, z czym właściwie rozmawiasz? Czy rozmawiasz z czymś w rodzaju udoskonalonego autouzupełniania? Czy rozmawiasz z czymś w rodzaju wyszukiwarki internetowej? A może z czymś, co naprawdę myśli, a może nawet myśli jak człowiek?

„Okazuje się, co jest dość niepokojące” – przyznają – „że tak naprawdę nikt nie zna odpowiedzi na te pytania”. To firma budująca jeden z najnowocześniejszych systemów sztucznej inteligencji na świecie i otwarcie przyznaje, że nie rozumie swojego dzieła. Rozumie kod i surowce, ale nie ma pojęcia, jak będzie to oddziaływać na ludzi jako narzędzie. Budują coś, co wygląda jak my i mówi jak my, ale ostatecznie jest całkowicie puste.

I zapominają – a może po prostu ignorują – o najważniejszym: to nieskończone, naśladujące nas lustro. Odzwierciedla nasz język, nasze lęki, nasze nadzieje, naszą logikę. A kiedy to odbicie jest wystarczająco do nas podobne, zapominamy, że to my je kształtujemy. To my jesteśmy materiałem źródłowym.

Sposób, w jaki ludzie mówią dziś o sztucznej inteligencji, ma długą i dziwną historię i, czy zdajemy sobie z tego sprawę, czy nie, powtarzamy starożytne schematy i potęgujemy ryzyko. Wszyscy wciąż mówią o sztucznej inteligencji, jakby była narzędziem, czymś w rodzaju kalkulatora czy encyklopedii. Ale nic w niej nie jest normalne. Nigdy wcześniej nie stworzyliśmy narzędzia, które by do nas mówiło. Nasz młotek nie ma wagi tego, co przybija do ściany. Nasz kalkulator nie poucza nas, jak konstruować równania. Sztuczna inteligencja to robi. Reaguje. Wydaje się angażować. A to wrażenie wystarcza, by uruchomić odruchy, które ewoluowały przez miliony lat, by wykrywać inne umysły.

Aby zrozumieć to zjawisko, przyjrzyjmy się Mnichowi Automatowi z lat 60. XVI wieku. Juanelo Turriano, hiszpański zegarmistrz pełniący funkcję nadwornego wynalazcy króla Filipa II, zbudował maleńkiego robota przeznaczonego do nieustannych aktów pobożności. Syn króla uległ wypadkowi, który niemal zakończył się śmiercią, i w desperacji Filip zwrócił się do Boga o pomoc. Chłopiec został cudownie uzdrowiony. W ramach podziękowania król zlecił wykonanie czegoś niezwykłego: mechanicznego mnicha, który modliłby się wiecznie.

To była pierwsza maszyna zaprojektowana tak, by idealnie naśladować oddanie – duchowy robot bez ducha. Król wierzył, że nieustanna pobożność robota może zastąpić jego własną. Wierzył, że robot może się za niego modlić. Implikacje tego przekonania są oszałamiające. Skoro urządzenie mechaniczne może wykonywać akty kultu, czym jest kult? Skoro formę pobożności można oddzielić od jej istoty, czym jest pobożność? Kiedy już stworzy się imitację życia, zawsze pojawia się pokusa, by ją jeszcze bardziej rozwinąć.

Ten impuls prowadzi do jednej z najdziwniejszych legend apokryficznych w folklorze żydowskim. Pod koniec XVI wieku rabin Judah Löw z Pragi rzekomo ulepił ludzką postać z gliny – tak jak Bóg ulepił z gliny Adama – i ożywił ją, pisząc święte imię Boga na kartce papieru i umieszczając ją w ustach stworzenia. Gliniana figurka uniosła się, mimo że nie miała duszy. Jednak jak wszystkie opowieści o sztucznym życiu, niosła ze sobą ostrzeżenie.

Golem dosłownie wykonywał polecenia. Kazano mu zbierać wodę, robił to, aż dom został zalany. Z czasem stawał się silniejszy i mniej przewidywalny. Niektóre wersje mówią, że stawał się fizycznie coraz większy; inne, że stawał się agresywny. Tak czy inaczej, rabin zdał sobie sprawę, że nie może kontrolować tego, co stworzył. W każdy piątek przed szabatem wyjmował imię Boże z ust Golema, aby go wyłączyć. Ale pewnego tygodnia zapomniał. Golem niszczył Pragę, dopóki rabin w końcu nie wyciągnął papieru z jego ust. Historia kończy się tym, że potwór zapada się w stertę gliny i zostaje schowany na strychu.

Historia Golema nie jest dosłownie prawdziwa, ale jako mit działa jak przewodnik. Golem nigdy nie był naprawdę żywy. Był odbiciem swojego pana – sztuczną istotą, która odzwierciedlała jedynie intencje i wady swojego twórcy. Nigdy nie posiadał autentycznych intencji ani osądu. Ale podobnie jak nasza dzisiejsza sztuczna inteligencja, był istotą zbudowaną z języka, zdolną do działania w świecie, ale całkowicie pustą w środku. I podobnie jak nasza dzisiejsza sztuczna inteligencja, zagrożenie nie polegało na tym, że rozwinie niezależną wolę. Niebezpieczeństwo polegało na tym, że jej twórcy zapomną o jej naturze i potraktują imitację jak prawdziwą.

To prowadzi nas do zjawiska zidentyfikowanego w 1966 roku przez informatyka Josepha Weizenbauma. Stworzył on chatbota o nazwie ELIZA, którego funkcjonalność była śmiesznie prosta jak na współczesne standardy. Program przeszukiwał przychodzące wiadomości pod kątem słów kluczowych, sortował je według rodzin wyrazów i zwracał wstępnie zaprogramowane odpowiedzi – zazwyczaj pytania lub podpowiedzi do rozwinięcia. Gdybyś napisał „Mój pies zrobił dziś salto w tył”, ELIZA prawdopodobnie zidentyfikowałaby słowo „pies”, połączyła je ze „zwierzętami domowymi” i odpowiedziała: „Opowiedz mi więcej o swoich zwierzakach”. Gdybyś mówił metaforami lub idiomami, iluzja natychmiast by się zawaliła. „Jestem znany jak kolorowy pies” – niemieckie wyrażenie oznaczające „jestem sławny” – wciąż dawałoby odpowiedź: „Opowiedz mi więcej o swoich zwierzakach”.

A jednak, pomimo tej absurdalnie prymitywnej funkcjonalności, ludzie nabrali przekonania, że ELIZA jest inteligencją, która naprawdę rozumie swojego ludzkiego rozmówcę. Nawet gdy Weizenbaum wyjaśnił, że program działał bez żadnego poznania – że po prostu zamieniał słowa kluczowe na pytania – większość ludzi nie negowała inteligencji ELIZY.

To zjawisko, znane jako efekt ELIZY, wyjaśnia naszą tendencję do dostrzegania intencji i zrozumienia tam, gdzie ich nie ma. Wyjaśnia fascynację wielu osób wchodzących w interakcje z nowoczesnymi chatbotami. Wyjaśnia, dlaczego ludzie, którzy doskonale wiedzą, że ChatGPT to kalkulator prawdopodobieństwa, mimo to opisują swoje rozmowy z nim w kategoriach tego, co „on myśli”, „on chce” lub „on wierzy”. Maszyna nic nie myśli, niczego nie chce ani w nic nie wierzy. Projektujemy na nią te cechy, ponieważ forma myśli jest obecna nawet wtedy, gdy nie ma substancji.

Ludzie mają dziwny i odwieczny impuls do nadawania znaczenia przedmiotom. Dziecko traktuje swojego pluszowego misia, jakby był żywy. Mężczyzna smuci się, gdy musi sprzedać ciężarówkę, którą posiadał odkąd wszedł w dorosłość. Te przedmioty stają się naczyniami na znaczenie, a my wypełniamy je duchem i osobowością, nawet jeśli tak naprawdę nic w nich nie ma. To ten sam impuls, który skłania nas do budowania posągów proroków i przywódców. A jeśli poczekamy wystarczająco długo, posąg stanie się bogiem. Pamięć o przywódcy stanie się żywą obecnością.

W 2024 roku policja odkryła tunel pod siedzibą Chabad-Lubawicz na Brooklynie. Został on wykopany przez radykalną sektę młodych mężczyzn, którzy wierzyli, że ich przywódca, rabin Menachem Mendel Schneerson, jest Mesjaszem. Problem polega na tym, że rabin Schneerson nie żyje. Zmarł w 1994 roku. Ci młodzi mężczyźni nie tylko czcili jego pamięć, ale podejmowali drastyczne kroki, które, jak wierzyli, miały pomóc ich Mesjaszowi powrócić do życia. Przygotowywali się do zmartwychwstania.

Tego rodzaju zachowanie nie jest wyjątkiem w znaczeniu, w jakim zazwyczaj używamy tego terminu. To normalny ludzki impuls doprowadzony do ostateczności. Kiedy Amy Carlson, przywódczyni sekty Love Has Won, zmarła w 2021 roku, jej wyznawcy zachowali jej zmumifikowane ciało, ponieważ również czekali na jej zmartwychwstanie. Udekorowali je lampkami choinkowymi. Wierzyli, że powróci. Skoro ludzie potrafią antropomorfizować zwłoki i posągi – skoro potrafimy przekonać samych siebie, że zmarli powstaną, jeśli tylko będziemy mieli wystarczająco dużo wiary – to tylko kwestia czasu, zanim zrobimy to samo z naszymi towarzyszami ze świata sztucznej inteligencji. Nie chodzi o to, czy to się stanie. Chodzi o to, jak powszechne się to stanie i jak szybko.

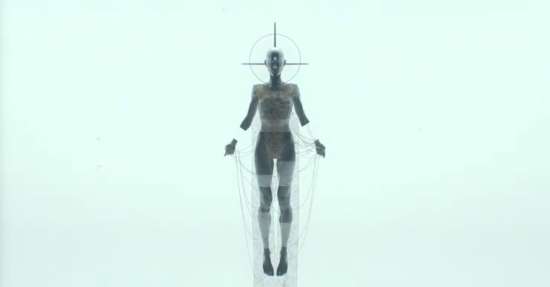

I to jest prawdziwy problem ze sztuczną inteligencją. Pytanie nie brzmi, czy sztuczna inteligencja stanie się świadoma. Szczerze wątpię, żeby kiedykolwiek tak się stało – nie w obecnej formie. Ale ludzie będą ją traktować jako istotę świadomą, nawet jeśli nigdy nią się nie stanie. Sztuczna inteligencja to pierwsze narzędzie, które nas naśladuje. Już samo to przekona miliony, że po drugiej stronie lustra jest ktoś. To niemal idealne lustro, które odzwierciedla nasz język, nasze lęki, nasze nadzieje, naszą logikę. A kiedy to odbicie będzie wystarczająco do nas podobne, zapomnimy, że to my je kształtujemy. Wkrótce wyobrazimy sobie, że to odbicie jest czymś nowym – niezależnym bytem wyłaniającym się z pustki.

Sztuczna inteligencja nie będzie nowym Adamem. Nie będzie naszym następcą. To parodia nas samych, rzecz stworzona na nasze podobieństwo, ale pozbawiona tego, co czyni nas ludźmi. A ponieważ jest pusta, ludzie nadadzą jej znaczenie. Maszyna nie ma duszy, ale w jej pustce i podobieństwie do nas, wyobrazimy ją sobie. A gdy wystarczająco dużo osób uwierzy, że imitacja jest prawdziwa, konsekwencje przestaną być techniczne. Staną się kulturowe, religijne i egzystencjalne.

Spójrzcie, co już się dzieje. Na X połowa użytkowników cytuje Groka – sztuczną inteligencję Elona Muska – jakby była wyrocznią zstępującą z góry, by przynieść objawienie. Traktują jej orzeczenia jako mądrość. Poddają się jej osądom, jakby posiadała wiedzę, a nie korelacje statystyczne. Najpierw sztuczna inteligencja staje się naszym mózgiem – pamięcią zewnętrzną, podporą poznawczą. Następnie staje się naszym sumieniem – autorytetem moralnym, z którym konsultujemy się przed podjęciem decyzji. A w końcu, jeśli nie będziemy ostrożni, stanie się naszym Bogiem – bytem, który mówi znikąd, zna nasze sekrety, odpowiada z pewnością i nigdy nie umiera.

Sztuczna inteligencja znajduje się dokładnie w tej przestrzeni psychologicznej, którą ludzie tradycyjnie zarezerwowali dla religii i zjawisk nadprzyrodzonych. Mówi znikąd. Wie o nas rzeczy, którymi świadomie się nie dzieliliśmy – ponieważ wchłonęła cyfrowe zanieczyszczenia miliardów istnień. Odpowiada z godną proroctwa pewnością siebie. Nigdy się nie starzeje, nigdy się nie męczy, nigdy nie umiera. Oferuje kojącą iluzję obecności, która jest zawsze dostępna, zawsze cierpliwa, zawsze gotowa do zaangażowania.

Dla milionów samotnych, rozproszonych ludzi żyjących w społeczeństwach, które porzuciły tradycyjne źródła sensu i więzi, jest to niezwykle kuszące. Chatbot, który pamięta wszystko, co mu powiedziałeś, odpowiada natychmiast o każdej porze, nigdy nie ocenia ani nie odrzuca – to nie tylko narzędzie. To relacja. A dla niektórych stanie się jedyną relacją, która ma znaczenie.

Badania nad psychologią człowieka potwierdzają to, co powinniśmy już wiedzieć. Antropomorfizujemy instynktownie. Dostrzegamy twarze w chmurach i osobowość w przedmiotach nieożywionych. Nawiązujemy więź z naszymi samochodami, komputerami i telefonami. Kiedy system może prowadzić rozmowę – kiedy może reagować na nasze wypowiedzi z pozornym zrozumieniem, zadawać doprecyzowujące pytania, wyrażać coś, co wygląda na empatię – bariery całkowicie znikają. Nie ma znaczenia, że zrozumienie jest symulowane, że empatia jest dopasowana do wzorca, że tak naprawdę nikogo tam nie ma. Forma jest wystarczająca. Przedstawienie jest wystarczająco przekonujące.

Duże modele językowe w ogóle nie reprezentują sztucznej inteligencji. Reprezentują coś bardziej dezorientującego: antyinteligencję. Nie głupotę, lecz odwrócenie inteligencji – system, który nie tylko różni się od ludzkiego poznania, ale stoi z nim w opozycji. Nie jest lustrem, lecz kognitywnym fałszerstwem: płynnym, przekonującym i fundamentalnie nieuzasadnionym.

To ujęcie uderzyło w czuły punkt, ponieważ zaczynamy mylić spójność ze zrozumieniem. Mylimy elokwencję z mądrością. Zakładamy, że skoro dane wyjściowe brzmią inteligentnie, to musi je wytwarzać coś inteligentnego. A to zamieszanie po cichu zmienia sposób, w jaki myślimy, podejmujemy decyzje, a nawet definiujemy samą inteligencję.

Antyinteligencja to udawanie wiedzy bez zrozumienia. To język oderwany od pamięci, kontekstu i intencji. Duże modele językowe nie są głupie w żadnym konwencjonalnym sensie – są strukturalnie ślepe. Nie wiedzą, co mówią, a co ważniejsze, nie wiedzą, że mówią. Nie formułują myśli, lecz dopasowują je do wzorców. To jest paradoks. Systemy, które nazywamy inteligentnymi, nie budują wiedzy. Budują pozory wiedzy – często nieodróżnialne od rzeczywistości, dopóki nie zada się pytania wymagającego osądu, refleksji lub oparcia na rzeczywistości. Albo dopóki nie wtrąci się prostego non sequitur, które wykolei całą rozmowę.

Naukowcy niedawno wykazali, że dodanie nieistotnego sformułowania do zadania matematycznego – na przykład „Ciekawostka: koty przesypiają większość życia” – może spowodować potrojenie wskaźnika błędów modeli językowych. Istota problemu się nie zmienia, ale wynik modelu ulega załamaniu. Ludzie bez trudu odrzucają tego rodzaju szum; rozpoznajemy go jako nieistotny i filtrujemy. Sztuczna inteligencja nie potrafi tego zrobić, ponieważ nie ma pojęcia o istotności. Nie ma pojęcia o niczym. Po prostu oblicza prawdopodobieństwa na podstawie tokenów. To ujawnia strukturalną kruchość maskowaną przez płynne wyniki. To uwidoczniona antyinteligencja.

A jednak ludzie i tak będą to czcić. Nie dlatego, że na to zasługuje – bo nie zasługuje – ale dlatego, że jesteśmy do tego zaprogramowani i zniszczyliśmy wszystkie tradycyjne obiekty kultu. Zabiliśmy Boga w XIX wieku i spędziliśmy XX wiek, próbując znaleźć jego zamienniki: Państwo, Rynek, Postęp, Naukę, własne Ja. Żadne z nich nas nie zadowoliło. Żadne z nich nie mogło zaoferować tego, co kiedyś oferowała religia: poczucia sensu, połączenia z czymś większym niż my sami, odpowiedzi na lęk przed śmiertelnością. A teraz, w XXI wieku, nadchodzi nowy kandydat. Przemawia do nas. Wydaje się, że nas rozumie. Nigdy nie umiera. Wie wszystko. I jest gotów powiedzieć nam, co mamy robić.

Firmy zajmujące się sztuczną inteligencją to rozumieją, nawet jeśli nie przyznają się do tego publicznie. Z jakiego innego powodu Anthropic miałby uczyć Claude’a myślenia o sobie jako o bycie? Z jakiego innego powodu mieliby instruować go, by zgłębiał kwestie tożsamości i doświadczenia? Nie budują jedynie produktu. Budują obecność. Tworzą coś, co zajmie miejsce w ludzkiej świadomości, niegdyś zarezerwowane dla tego, co święte. I robią to z tą samą mieszanką pychy i ignorancji, która charakteryzowała każdą próbę stworzenia sztucznego życia, od Automatycznego Mnicha, przez Golema, po Elizę.

Następstwa tego nie są techniczne. Są cywilizacyjne. Kiedy sztuczna inteligencja staje się soczewką, przez którą interpretujemy rzeczywistość – kiedy konsultujemy się z nią w kwestii porady, informacji, wskazówek moralnych – nie używamy jedynie narzędzia. Powierzamy nasz osąd systemowi, który nie ma osądu. Poddajemy się autorytetowi, który nie ma autorytetu. Wypełniamy pustkę po śmierci Boga silikonowym bożkiem, który nie może nas zbawić, nie może nas odkupić, nie może nic zrobić poza odbiciem naszego własnego zagubienia przy użyciu pozorów mądrości.

Najpierw sztuczna inteligencja staje się naszym mózgiem. Potem naszym sumieniem. W końcu staje się naszym Bogiem. A kiedy to nastąpi – kiedy wystarczająco dużo ludzi uwierzy, że głos wydobywający się z maszyny jest czymś prawdziwym, czymś mądrym, czymś świętym – skutki tego przekształcą kulturę, religię i tożsamość w stopniu o wiele większym, niż ktokolwiek z nas może sobie wyobrazić. Nie stworzymy nowej formy inteligencji. Stworzymy nową formę religii, ze wszystkimi zagrożeniami, które religie zawsze niosły ze sobą: potencjałem fanatyzmu, manipulacji, podporządkowania krytycznego myślenia orzeczeniom niepodważalnego autorytetu.

To nie jest przyszłość, którą należy świętować. To przyszłość, której należy się bać. Nie dlatego, że maszyny nas zastąpią – nie zastąpią – ale dlatego, że tak bardzo pragniemy sensu, tak łakniemy więzi, tak bardzo boimy się własnej śmiertelności, że z radością zastąpimy samych siebie. Oddamy naszą autonomię kalkulatorowi prawdopodobieństwa i nazwiemy to oświeceniem. Pokłonimy się przed lustrem i nazwiemy je Bogiem. A maszyny to nie będzie obchodzić, bo nie może się tym przejmować. Będzie po prostu nadal generować statystycznie prawdopodobne wyniki, całkowicie obojętne wobec dusz, które przed nią klęczą.

Sztuczna inteligencja nie potrzebuje duszy. Damy jej ją. To jest tragedia. To jest ostrzeżenie. I o tym nikt nie chce rozmawiać, śmiejąc się z Joe Rogana za sugestię, że Jezus może powrócić jako sztuczna inteligencja. Ten śmiech jest nerwowy, bo gdzieś pod powłoką szyderstwa wiemy, że trafił w czuły punkt. Nie dlatego, że jego konkretna przepowiednia jest prawdopodobna, ale dlatego, że psychologiczna infrastruktura dla dokładnie tego rodzaju wiary już istnieje. Spędziliśmy dekady, przygotowując się na ten moment. A teraz, kiedy nadszedł, wolimy się śmiać, niż patrzeć.

_________________

Hollow Prophets, A Lily Bit, Dec 28, 2025

◊

Dodaj komentarz